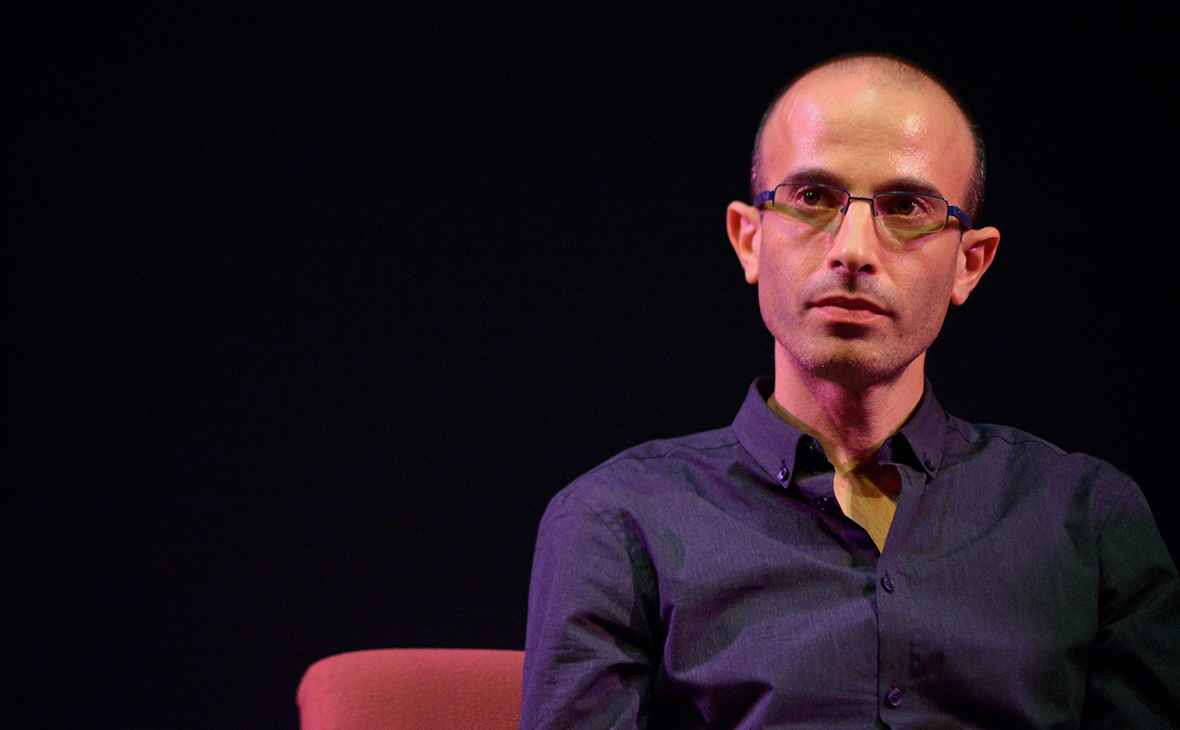

Юваль Харари предупредил о появлении алгоритмов-расистов

В интервью РБК израильский историк Юваль Харари отметил, что алгоритмы, которые программисты создают для анализа поведения людей, часто являются предвзятыми.

«Они отражают предубеждения своих разработчиков. Это ведь выдумка, что алгоритмы действуют на основе чистой математики. Разработчик сообщает программе, на какую информацию она должна обращать внимание, а какую — пропускать. Например, вы пишете алгоритм, который решает, давать людям заем или нет, изучая разнообразную информацию о заемщике. Должен ли этот алгоритм принимать во внимание расу заемщика? Должен ли он отказывать человеку на том основании, что он черный, еврей, гей или женщина? Дизайнер алгоритма вполне может вложить свои предубеждения в программу», — утверждает Харари.

Историк считает, что в ближайшем будущем подобные предубеждения, которые разработчик намеренно или бессознательно вкладывает в алгоритм, могут превратиться в новый источник дискриминации людей по их расе, полу и сексуальной ориентации.

К дискриминации могут приводить и полностью объективные алгоритмы: например, искусственный интеллект, который помогает банкам снизить число неплатежей по кредитам. Но моральная ответственность все равно лежит на служащих, принимающих решения по каждому заемщику: «Даже если программа подсчитает, что представители какой-то конкретной этнической группы с меньшей вероятностью возвращают займы, вам все равно надо спросить себя: а почему это происходит? Может быть, они на протяжении десятилетий страдают от дискриминации, из-за которой бедны, плохо образованы и враждебны по отношению к любым социальным институтам? И именно поэтому с меньшей вероятностью гасят кредиты? Тогда к несправедливостям, которые им причиняли, вы добавите собственную несправедливость, сославшись на беспристрастное решение алгоритма», — отмечает ученый.