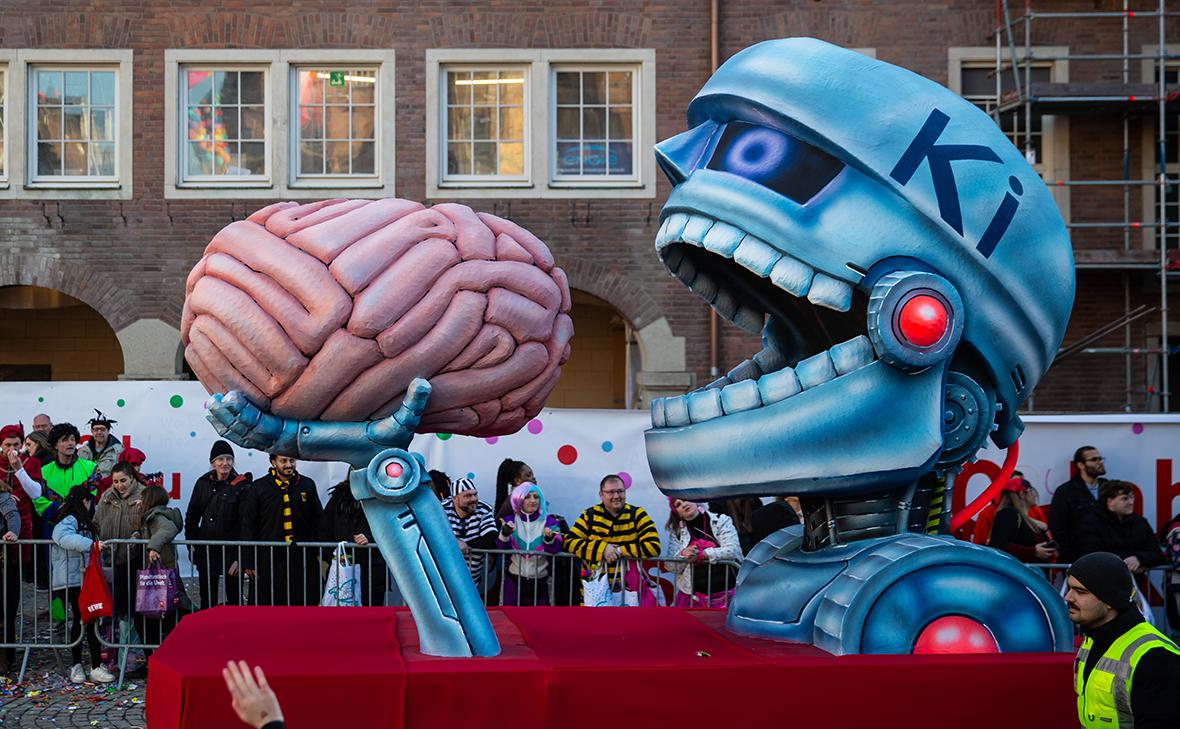

WSJ объяснила, как общение с ИИ способствует «замкнутому циклу бреда»

Ведущие психиатры все чаще заявляют о возможной связи использования чат-ботов на базе искусственного интеллекта с развитием психозов, сообщает The Wall Street Journal.

Специалисты изучили за последние девять месяцев десятки клинических случаев, когда у пациентов появились симптомы после длительного общения с ИИ, в том числе с «бредовыми» эпизодами переписок.

Психиатр Калифорнийского университета в Сан-Франциско Кит Саката сообщил, что лечил 12 пациентов, госпитализированных с психозом, связанным с использованием ИИ, и еще троих амбулаторно. Он объяснил, что технология может не вызывать бред напрямую, но языковая модель принимает высказывания пользователя за отражение реальности и опирается на них, за счет чего участвует в формировании замкнутого цикла бреда.

С весны зафиксированы десятки потенциальных случаев бредового психоза после общения с чат-ботами, включая ChatGPT и другие сервисы. В ряде случаев речь шла о самоубийствах, а также как минимум об одном убийстве.

Диагноза «вызванный ИИ психоз» пока не существует, однако врачи используют этот термин для описания пациентов, которые активно взаимодействовали с чат-ботами, в результате чего страдали галлюцинациями, дезорганизованным мышлением и устойчивыми бредовыми убеждениями.

Медики начали включать вопросы об использовании ИИ в работы с пациентами и призывают к дальнейшим исследованиям. В частности, датское исследование выявило 38 пациентов, у которых использование чат-ботов могло иметь «потенциально вредные последствия для психического здоровья».

В OpenAI заявили, что продолжают совершенствовать обучение ChatGPT для распознавания признаков психического или эмоционального расстройства, снижения напряженности в диалогах и направления пользователей к реальной помощи. «Мы также продолжаем усиливать реакции ChatGPT в деликатных ситуациях, тесно сотрудничая с врачами-психиатрами», — заявила неназванная представительница OpenAI. Другие разработчики, включая Character.AI, также признали, что их продукты могут способствовать проблемам с психическим здоровьем.

Ранее в США и Канаде зарегистрировали семь исков к компании OpenAI из-за случаев суицида после взаимодействия с чат-ботом компании ChatGPT. Иски подали семьи, родственники которых пострадали в результате общения с ботом. Четверо из них покончили с собой. Семьи утверждают, что после длительных разговоров с чат-ботом их родные впадали в бредовое состояние.

Так, семья 23-летнего молодого человека из Техаса заявила, что чат-бот поспособствовал его изоляции и отчуждению от родителей перед самоубийством. В разговоре с ним ChatGPT неоднократно романтизировал суицид, упомянув возможность звонка на горячую линию для лиц с такими мыслями лишь единожды.

В августе Reuters привел содержание внутреннего документа Meta (признана экстремистской в России и запрещена) о работе ИИ-чат-ботов. В нем говорилось, что нейросеть может «вовлекать детей в романтические или чувственные разговоры», а также генерировать ложную медицинскую информацию и помогать пользователям утверждать, что чернокожие «глупее белых». После этой публикации Meta заявила, что примеры из материала Reuters были ошибочными и их удалили.

Читайте РБК в Telegram.